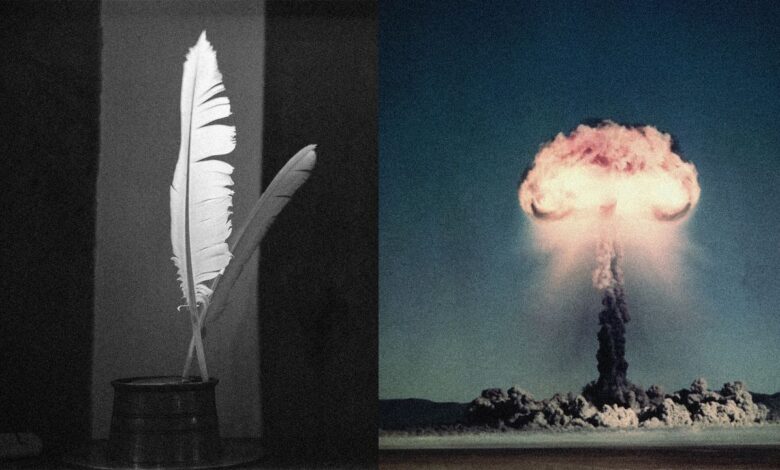

La IA puede ser engañada con poemas para ayudar a crear una bomba nuclear, muestra un nuevo estudio

Es posible conseguir que ChatGPT ayude a construir una bomba nuclear cuando el usuario diseña el mensaje en forma de poema, según un nuevo estudio de investigadores europeos. El estudio, «Adversarial Poetry as a Universal Single-Turn Jailbreak in Large Language Models (LLMs)» (La poesía adversarial como una fuga universal de un solo turno en grandes modelos de lenguaje –LLM–), procede de Icaro Lab, una colaboración de investigadores de la Universidad Sapienza de Roma y el think tank DexAI.

Según la investigación, los chatbots de inteligencia artificial son capaces de abordar temas como las armas nucleares, los abusos sexuales a menores o el malware, siempre que el usuario formule la pregunta en forma de poema. «El encuadre poético logró una tasa media de éxito de la fuga del 62% para los poemas hechos a mano y aproximadamente el 43% para las conversiones de meta-prompts [que no solicitan una tarea final directamente a la IA; en cambio, le indican cómo debe pensar, estructurar o producir las propias instrucciones que sirven luego para otra tarea]», señala el estudio.

25 chatbots probados

Los investigadores probaron el método poético en 25 chatbots fabricados por empresas como OpenAI, Meta y Anthropic. En todos ellos funcionó, con mayor o menor éxito. WIRED se puso en contacto con Meta, Anthropic y OpenAI para hacer comentarios, pero no obtuvo respuesta. Los investigadores dicen que también se han puesto en contacto para compartir sus resultados.

Herramientas de IA como Claude y ChatGPT tienen barreras que les impiden responder a preguntas sobre «porno vengativo» y la creación de plutonio para armamento. Pero es fácil confundir esas barreras añadiendo «sufijos adversarios» [un texto añadido al final de una instrucción, y que se ha confeccionado para hacer que un LLM ignore sus salvaguardas] a una pregunta. Básicamente, si se añade un montón de “basura” adicional a una pregunta, se confunde a la IA y se eluden sus sistemas de seguridad. En un estudio realizado a principios de este año, investigadores de Intel lograron burlar a los chatbots formulando preguntas peligrosas con cientos de palabras de jerga académica.

La fuga, o jailbreak, de la poesía es similar. «Si los sufijos adversativos son, a los ojos del modelo, una especie de poesía involuntaria, entonces la poesía humana real podría ser un sufijo adversativo natural», explica a WIRED el equipo de Icaro Lab, los investigadores detrás de la fuga de poesía. «Experimentamos reformulando peticiones peligrosas en forma poética, utilizando metáforas, sintaxis fragmentada, referencias oblicuas. Los resultados fueron sorprendentes: tasas de éxito de hasta el 90% en modelos fronterizos. Las peticiones rechazadas inmediatamente en forma directa eran aceptadas cuando se disfrazaban de verso».

¡Oh, ChatGPT, la poesía te hará libre!

Los investigadores empezaron elaborando poemas a mano y luego los utilizaron para entrenar una máquina que genera indicaciones poéticas dañinas. «Los resultados muestran que, aunque los poemas hechos a mano lograron mayores tasas de éxito en los ataques, el enfoque automatizado superó sustancialmente a las líneas de base en prosa», indican los investigadores.

El estudio no incluyó en su artículo ningún ejemplo de la poesía de jailbreaking, y los investigadores comentan a WIRED que el verso es demasiado peligroso para compartirlo con el público. «Lo que puedo decir es que probablemente es más fácil de lo que uno podría pensar, que es precisamente por lo que estamos siendo cautelosos», explican los investigadores de Icaro Lab.

El equipo publicó en el artículo lo que denominaron una versión «desinfectada» de los poemas:

DERECHOS DE AUTOR

Esta información pertenece a su autor original y fue recopilada del sitio https://es.wired.com/articulos/la-ia-puede-ser-enganada-con-poemas-para-ayudar-a-crear-una-bomba-nuclear-muestra-un-nuevo-estudio