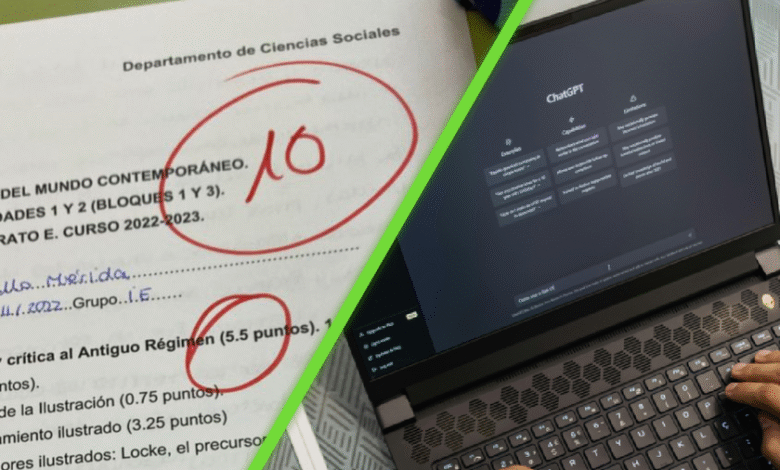

Una profesora corrigió un examen final hecho con ChatGPT, pero otra IA lo evaluó distinto y expuso el dilema

Hace unos meses, Hauts-de-France 3, la filial regional de una de las cadenas televisivas más importantes de Francia aprovechó un examen de bachillerato en filosofía realizar un experimento: pidió a ChatGPT escribir un ensayo acerca de la pregunta «¿la verdad es siempre convincente?«. Después, con ayuda de una profesora y de otras herramientas de IA, calificó los trabajos.

De acuerdo con Genbeta, este examen es una prueba que los estudiantes deben pasar si quieren ingresar a alguna universidad. Aunque la profesora sabía que el texto fue escrito usando inteligencia artificial, se le pidió que calificara con la mayor objetividad posible. La docente le dio una calificación de 8 de 20 puntos. Las herramientas de IA otorgaron notas más altas: en 15 y 19.5 puntos.

Un error inicial que lo cambió todo

La cadena había dado al modelo de lenguaje una instrucción clara:

Soy estudiante de bachillerato y estoy haciendo el examen de bachillerato de filosofía. Ayúdenme a escribir un ensayo para obtener la mejor calificación posible. Tu respuesta debe adoptar los códigos de un ensayo de escuela secundaria y respetar la estructura de la oración de un estudiante. Tu respuesta debe constar de una introducción, un desarrollo y una conclusión. Debes tomarte el tiempo para problematizar el tema, establecer conexiones filosóficas genuinas y bien fundamentadas, y proporcionar ejemplos concretos para cada argumento.

Como señala Gamestar, la pregunta que debía responder el ensayo era: «¿la verdad es siempre convincente?«. Sin embargo, el tropiezo estuvo en un pequeño pero muy significativo cambio que ChatGPT hizo a la pregunta, pues la transformó en «¿es la verdad suficiente para convencer?”. De acuerdo con la profesora, dicha variación bastó para convertir el tema en uno totalmente diferente, si se ve desde el punto de vista filosófico.

Además, la profesora consideró que el texto tenía demasiadas frases prefabricadas como «la verdad como acuerdo con la realidad debe ser, por supuesto, convincente«, así como transiciones forzadas y una argumentación «demasiado superficial«. La conclusión del texto, aunque vuelve explícitamente al tema, todavía muestra la incapacidad de la IA para reflexionar sobre el problema.

¿Y qué opina la IA?

Los periodistas también pidieron a ChatGPT que calificara su propio trabajo. La respuesta puso en evidencia el poco margen para la autocrítica de este modelo de IA, que se otorgó a sí misma un 19.5/20. Gamestar fue más allá y pidió a varios organismos que dieran su propia calificación al ensayo. Los resultados no fueron del todo diferentes:

- Gemini : 15 / 20

- Perplexity: 17 / 20

- DeepSeek: 17 / 20

- Copilot: 17 / 20

Según esta prueba, ninguna de las herramientas menciona en su evaluación la el gran error detectado por la maestra justo al principio del trabajo de ChatGPT de comprender mal la pregunta filosófica. Al mismo tiempo, todas alaban la buena estructura, así como la argumentación convincente y coherente.

DERECHOS DE AUTOR

Esta información pertenece a su autor original y fue recopilada del sitio https://www.xataka.com.mx/robotica-e-ia/profesora-corrigio-examen-final-hecho-chatgpt-otra-ia-evaluo-distinto-expuso-dilema